Docker安装Ollama

Ollama 官网

访问 Ollama 官方网站 获取更多关于 Ollama 的信息和支持。

Docker Compose 脚本

首先,我们需要创建一个 Docker Compose 文件来定义服务。打开终端并输入以下命令以创建 docker-compose-ollama.yml 文件:

vim docker-compose-ollama.yml接着,在文件中添加如下内容:

version: '3'

services:

ollama:

image: registry.cn-hangzhou.aliyuncs.com/xfg-studio/ollama:0.5.10

container_name: ollama

restart: unless-stopped

ports:

- "11434:11434"运行 Docker Compose 文件

保存并退出编辑器后,运行以下命令启动服务:

docker-compose -f docker-compose-ollama.yml up -d这将以后台模式启动 Ollama 服务。

检查服务是否正常运行

可以通过浏览器访问以下地址来确认 Ollama 是否已经成功运行:

http://localhost:11434/

可以在 Portainer 中查看 Ollama 的运行状态。参考以下截图示例:

使用命令行进入容器

为了执行命令或者进行调试,可以使用以下命令进入 Ollama 容器的交互式 shell:

docker exec -it ollama /bin/bash或者使用Portainer的命令行工具运行命令

Ollama 相关命令

在容器内部或通过 API 可以使用一系列 Ollama 命令来管理模型和服务:

启动服务:

ollama serve拉取模型:

ollama pull deepseek-r1:1.5b ollama pull nomic-embed-text列出所有已下载模型:

ollama list显示特定模型的信息:

ollama show model_name运行特定模型:

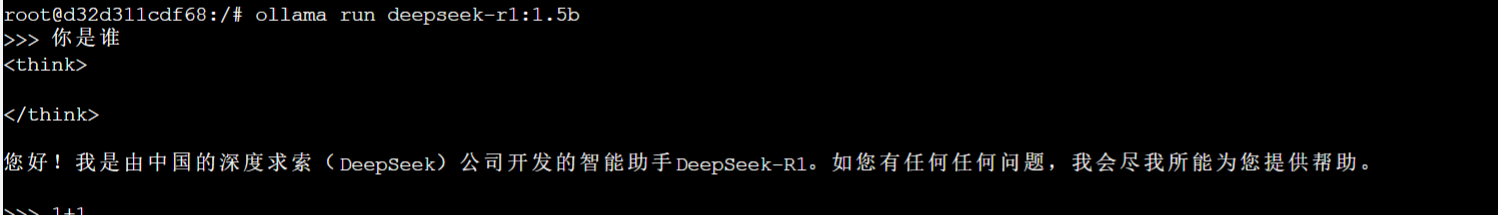

ollama run --gpu model_name停止正在运行的模型:

ollama stop model_id删除指定模型:

ollama rm model_name

可以通过查看 Ollama 的日志来帮助诊断。对于 Docker 容器,可以使用 docker logs`命令查看输出的日志信息。

docker logs ollama

连接WSL中的Ollama

贡献者

flycodeu

版权所有

版权归属:flycodeu